機械学習を実践していると、必ず出てくる「エポック数」という用語。このエポック数をどうやって決めればいいのか、初心者の方は悩んでしまうことが多いのではないでしょうか?この記事では、エポック数の基本から適切な決め方、注意点までを丁寧に解説します。特に初心者や独学中の方にとって、モデルの過学習や精度不足を防ぐためにも重要な知識です。

エポック数とは何か?基本を理解しよう

エポック数とは、機械学習モデルが訓練データ全体を何回繰り返して学習するかを示す指標です。たとえば、訓練データが1,000件あり、エポック数を10に設定した場合、モデルは同じデータを10回学習するということになります。

この繰り返しによってモデルの精度が向上する一方、やりすぎると過学習を引き起こす可能性があります。つまり、エポック数は「多すぎても少なすぎてもダメ」な、非常にデリケートなパラメータなのです。

エポック数を決める上で考慮すべきポイント

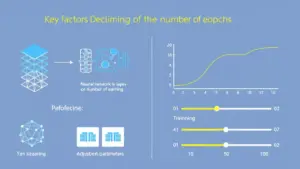

エポック数を設定する際は、以下のような要素を考慮する必要があります。

-

データセットのサイズ:データが少ないと過学習しやすいため、エポック数は控えめにするのが一般的です。

-

モデルの構造:深層学習のような複雑なモデルでは、多めのエポック数が必要になることがあります。

-

学習率(Learning Rate):学習率が高い場合、エポック数は少なめでもよく、低い場合は多めに設定することが多いです。

-

早期終了(Early Stopping)の有無:過学習を防ぐために、一定の基準で学習を途中で終了する仕組みを使うと、エポック数を多めに設定しても問題ありません。

エポック数の決め方に正解はあるのか?

実際のところ、エポック数の「正解」はデータやモデルによって異なります。そこで重要なのが、「検証データ(Validation Data)」を活用したエポック数の調整です。

検証データを使ってモデルの精度が頭打ちになるポイントを探ることで、エポック数の過不足を判断することができます。グラフで精度(Accuracy)や損失(Loss)の推移を可視化して、最適なエポック数を見極めましょう。

過学習を防ぐためのテクニック

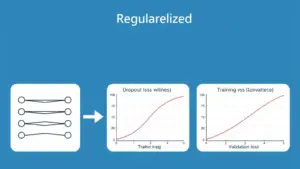

エポック数を増やすことで精度が向上するケースもありますが、同時に「過学習(オーバーフィッティング)」のリスクも高まります。

過学習を防ぐための主なテクニックとして、以下が挙げられます。

-

Early Stopping:一定期間、精度の改善が見られなければ自動的に学習を止める方法です。

-

ドロップアウト(Dropout):一部のノードを無効化して学習させることで、汎化性能を高めます。

-

正則化(Regularization):損失関数にペナルティを加えることで、過剰な学習を防ぎます。

これらのテクニックを併用することで、エポック数をある程度多めに設定しても安全に学習を進めることができます。

実際に試して調整することが最も重要

理論だけではなく、実際に複数のエポック数で学習を試してみることも非常に大切です。

たとえば、10・30・50エポックなど段階的に学習を実施し、各エポック数での検証データに対する精度を比較することで、最も適したエポック数を見つけることができます。

また、学習の進行状況を可視化して、どのタイミングで精度が頭打ちになるのか、または下降に転じるのかを見極める力も重要です。

まとめ

エポック数は、機械学習モデルの性能を大きく左右する非常に重要なパラメータです。適切なエポック数を設定するには、モデルの構造やデータの特徴、学習率などさまざまな要素を考慮する必要があります。

初心者の方にとっては、まずは小さめのエポック数からスタートし、検証データを用いて様子を見るのが安全です。そのうえで、Early Stoppingなどのテクニックを活用しながら、最適な学習回数を見つけていくようにしましょう。

エポック数の決め方をしっかりと理解し、効果的なモデル構築を目指していきましょう。

コメント